Deepseekの新しいチャットボットには、印象的な紹介があります。中国のスタートアップDeepseekの製品であるこのAIは、すぐに主要なプレーヤーになり、Nvidiaの株価の大幅な低下に貢献しています。

画像:Ensigame.com

画像:Ensigame.comDeepseekの成功は、革新的なアーキテクチャとトレーニング方法に由来しています。重要なテクノロジーには次のものがあります。

- マルチトークン予測(MTP):単語を個別に予測する代わりに、MTPは複数の単語を同時に予測し、精度と効率を高めます。

- 専門家の混合(MOE):このアーキテクチャは、Deepseek V3で256のニューラルネットワークを利用し、トークン処理タスクごとに8つをアクティブにし、トレーニングを加速し、パフォーマンスを向上させます。

- マルチヘッド潜在的注意(MLA): MLAは、テキストフラグメントから重要な詳細を繰り返し抽出し、重要な情報を確実に見逃さず、入力データのより微妙な理解につながります。

Deepseekは当初、Deepseek V3でわずか600万ドルのトレーニングコストがわずか600万ドルで、2048 GPUを使用していると主張しました。ただし、セミアナの癒しにより、はるかに広範なインフラストラクチャが明らかになりました。約50,000のNVIDIAホッパーGPU(10,000 H800、10,000 H100、および追加のH20を含む)が複数のデータセンターに広がっており、サーバーの合計投資と約9億4,400万ドルの運用費用を表しています。

画像:Ensigame.com

画像:Ensigame.com中国のヘッジファンドハイフライヤーの子会社であるDeepseekは、データセンターを所有しており、最適化とより高速なイノベーションの実装を管理しています。この自己資金によるアプローチは、柔軟性と意思決定を強化します。同社はトップの才能を引き付け、一部の研究者は主に中国の大学で年間130万ドル以上を稼いでいます。

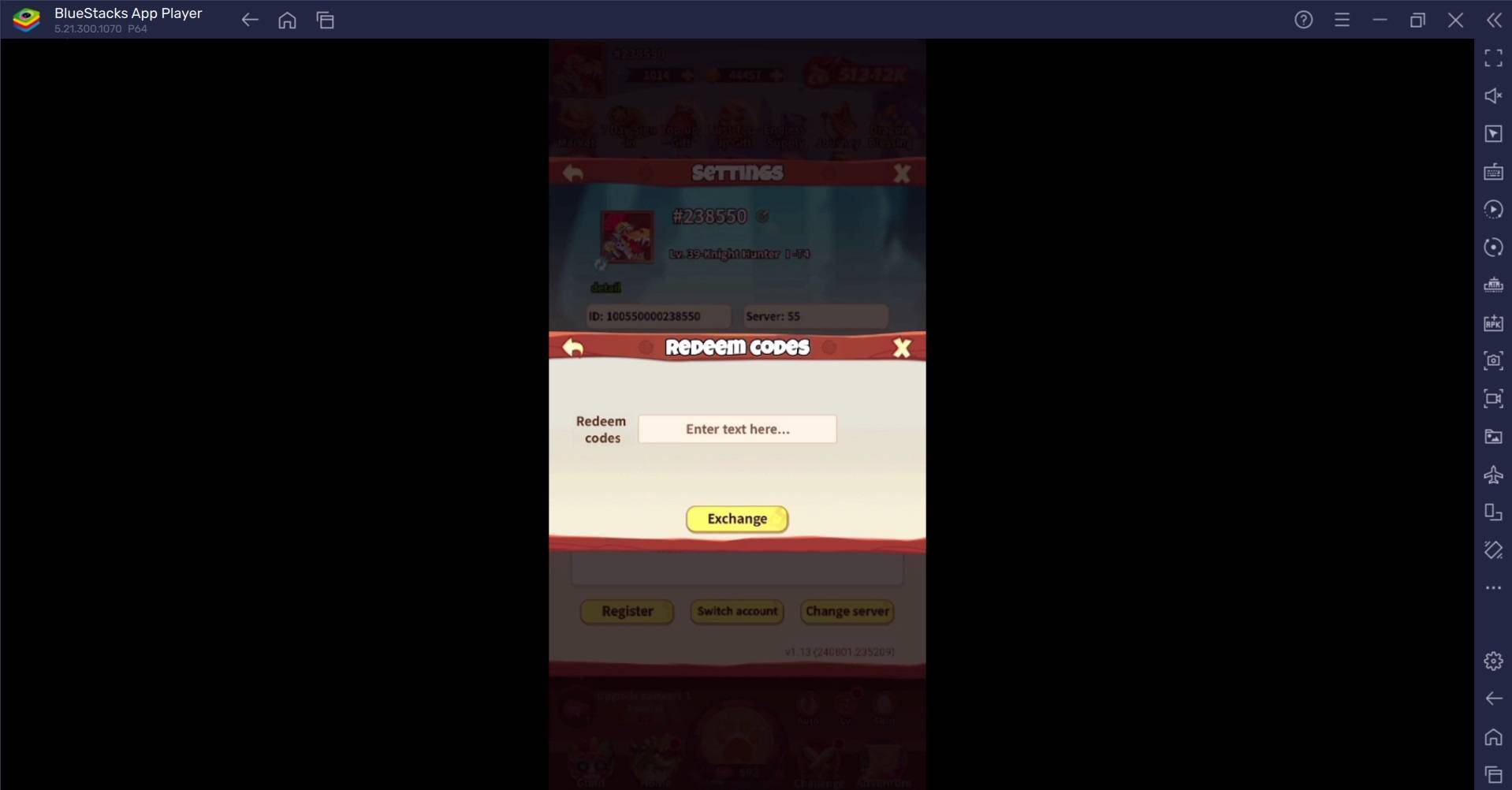

画像:Ensigame.com

画像:Ensigame.com600万ドルのトレーニングコストの請求は、研究、洗練、データ処理、インフラストラクチャを除く、トレーニング前のGPU使用のみを表す重要な控えめな表現であると思われます。 DeepseekのAI開発への実際の投資は5億ドルを超えています。それにもかかわらず、その無駄のない構造により、より大きな官僚的企業と比較して、効率的なイノベーションが可能になります。

画像:Ensigame.com

画像:Ensigame.comDeepseekの成功は、資金提供された独立したAI企業が業界の巨人と競争する可能性を強調しています。その「革新的な予算」の請求は誇張されていますが、その成功は大規模な投資、技術のブレークスルー、強力なチームに紛れもなくリンクされています。トレーニングコストを比較するとコントラストが厳しくなります:DeepseekのR1の費用は500万ドル、ChatGPT-4は1億ドルかかります。ただし、競合他社よりも安いです。

![Taffy Tales [v1.07.3a]](https://imgs.xfsxw.com/uploads/32/1719554710667e529623764.jpg)